Miembros del grupo de Investigación, Desarrollo e Innovación en Informática de la Universidad de Sevilla y expertos de la Universidad de Reutlingen (Alemania) han desarrollado un sistema de asistencia en la conducción eficiente y seguro basado en el comportamiento del conductor.

Esta tecnología adapta sus recomendaciones en tiempo real según el nivel de estrés que presente el usuario y la forma de conducción que esté llevando a cabo en ese instante.

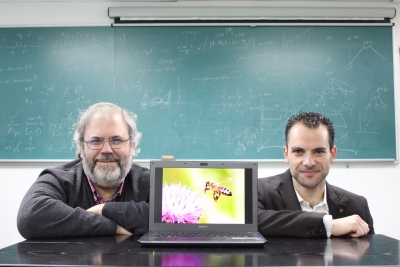

Es el resultado de la tesis doctoral del investigador Emre Yay, de la Escuela de Ingeniería Informática de Sevilla, que ha realizado bajo la dirección del profesor de la US Juan Antonio Ortega y de la profesora de la Universidad de Reutlingen Natividad Martínez.

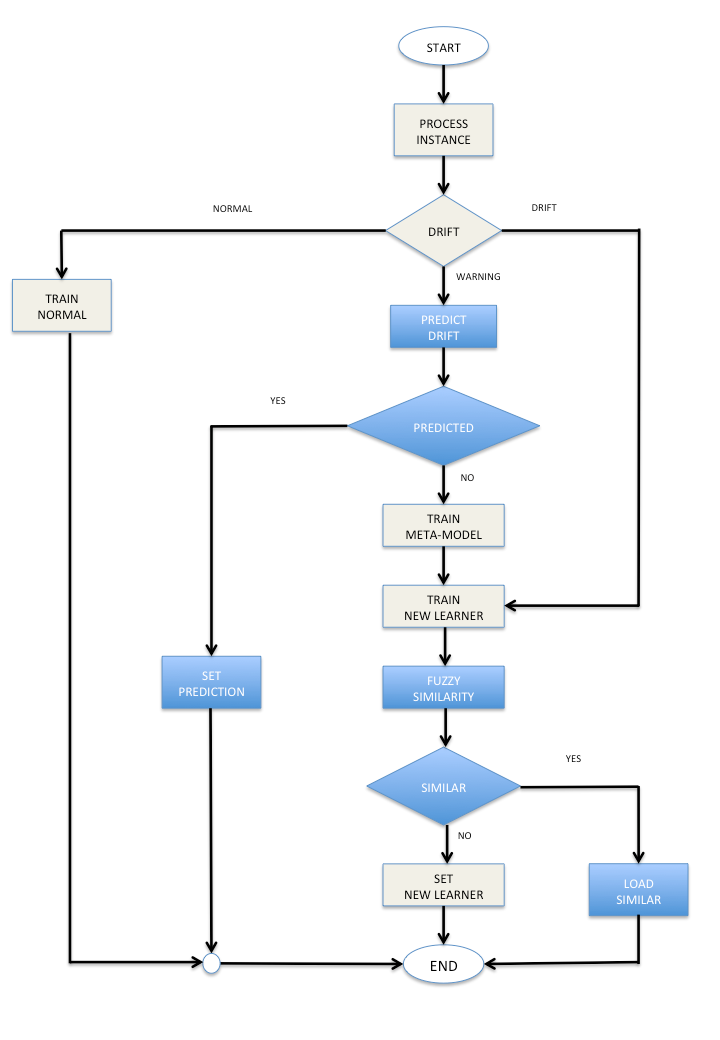

El sistema analiza la forma de conducir de la persona y su estado emocional a través la información que suministran una serie de indicadores del interior del automóvil como son la velocidad, los cambios de marcha o la aceleración, y unos sensores/pulseras de pulso que permiten conocer el nivel de estrés y nerviosismo del conductor en ese preciso momento.

“Con todos estos datos se van proporcionando al conductor una serie de indicaciones para una conducción segura y eficiente, pero si el usuario no sigue estas recomendaciones el sistema lo detecta y se encarga de adaptarlas a la realidad que está viviendo en ese instante el conductor”, explica Martínez, que añade que tratan «de dar indicaciones que no aumenten la carga de estrés del conductor para evitar que apague el dispositivo”.

Los nuevos estudios en computación centrada en la persona se centran también en señales táctiles que adviertan por ejemplo de un exceso de velocidad a través de la vibración del pedal del acelerador.

Según informa la US en una nota, Mercedes-Benz ha incorporado a su plantilla a Yay con el objetivo de poner a punto este sistema integrado para sus nuevos modelos de coches. Otras empresas como BMW o Porsche también cuentan con estudiantes de la Universidad de Reutlingen para el desarrollo de sistemas en coches de última generación.